Sommaire

L’arrivée de ChatGPT en 2022 a fait office de cataclysme dans le monde de l’Internet mais pas que. Technologie du futur jusque-là réservée aux passionnés, avec une utilisation pas toujours évidente, la sortie de ChatGPT le 30 novembre 2022 a drastiquement changé la donne.

En effet, la sphère médiatique s’est immédiatement emparée du mouvement. Il faut dire que l’efficacité de ce modèle de langage et son accessibilité furent véritablement impressionnantes. D’abord emprunte de stupéfaction, l’opinion publique s’est rapidement transformée en crainte pour l’avenir de l’humanité, notamment dans les métiers nécessitant des connaissances approfondies de certains sujets.

Pourtant, l’intelligence artificielle n’a pas été créée du jour au lendemain. ChatGPT, développé par l’entreprise OpenAI est l’aboutissement de nombreuses années de travail, passées à peaufiner un modèle de langage (NLP) toujours plus redoutable.

L’objectif de cet article est de comprendre d’où vient l’intelligence artificielle, son intégration progressive dans le web, et quelles sont les utilisations qui peuvent en découler aujourd’hui.

L’Intelligence artificielle : un changement majeur débuté depuis plusieurs années

Le NLP ou Natural Language Processing n’est pas nouveau. Cela fait plus de 10 ans que Google, et d’autres, investissent dans la recherche et le développement de technologies basées sur l’intelligence artificielle. Le NLP en fait parti.

Le traitement du langage naturel, c’est la capacité d’une machine à comprendre le sens des mots, le contexte, le ton, les émotions, etc. Il est évident que dans une logique de moteur de recherche, où l’objectif est d’afficher des résultats pertinents par rapport à une requête, la compréhension du contenu présent dans une page est primordiale.

L’arrivée de Google BERT

C’est en 2019, après plusieurs années de collaboration avec des ingénieurs que Google lance BERT (Bidirectional Encoder Representations from Transformers), censé améliorer la pertinence des réponses du moteur.

Fini alors les techniques peu qualitatives de keyword stuffing ou autre. Il est temps d’apprendre à rédiger correctement, proposant une véritable expertise et plus-value à l’utilisateur. En effet, l’algorithme de recherche ne traite plus les requêtes mot à mot, mais décrypte le contexte, afin de comprendre le sens des phrases dans leur ensemble.

L’évolution avec Google MUM

En 2021, Google sort MUM (Multitask Unified Model) qui vient encore améliorer la compréhension du langage par le moteur de recherche. Ce qu’il faut comprendre, c’est que le travail d’optimisation d’un contenu, jusqu’ici très mathématique en se basant sur des pourcentages d’occurrences, ou des méthodes de type TF-IDF devient dorénavant plus sémantique.

Le traitement de langage naturel, et donc la compréhension de phrases complètes comme une personne les prononceraient à l’oral offre une amélioration conséquente de la qualité des réponses et donc de l’expérience utilisateur.

Avec l’avènement de la recherche orale, c’est une évolution majeure et nécessaire.

Du moteur de recherche au moteur de réponse ou moteur conversationnel

Si l’intelligence artificielle est déjà intégrée depuis plusieurs années dans les algorithmes de recherche, pourquoi l’arrivée de ChatGPT a créé un bouleversement ?

Et bien, dans les usages, nous avons pu remarquer ces dernières années que les requêtes longues ou de type questions devenaient de plus en plus présentes. Il n’est plus rare aujourd’hui d’observer des volumes de recherche bien plus importants sur un mot clé longue traine plutôt que moyenne traine.

Au-delà du volume, Google comprenant mieux le contexte de notre recherche, les utilisateurs ont vite compris qu’en étant plus précis dans leur recherche, les résultats n’en seraient que plus pertinents.

Demandez à Google « quoi faire pendant un week-end à Saint-Malo ? » et vous devriez pouvoir remplir votre planning de visites et autres choses à voir en un rien de temps.

Le temps justement, est un facteur clé des changements opérés ces dernières années. Le temps de cerveau disponible diminue chaque jour un peu plus. L’objectif des entreprises aujourd’hui est de se faire une petite place dans le temps de cerveau disponible de chacun. Quelques minutes par ci, quelques minutes par là.

Des applications pour apprendre une langue étrangère en 5 min par jour, des méthodes de remises en forme avec un circuit de 7 min par jour, etc. Les exemples sont nombreux.

La méthode de recherche sur Internet évolue donc dans ce sens également. Les gens n’ont plus le temps de flâner et de chercher des réponses pendant des heures sur Internet.

Ils ne veulent plus d’un moteur de recherche, mais d’un moteur de réponse.

C’est là qu’intervient ChatGPT. En adaptant leur modèle de langage GPT-3 dans un environnement de chat et d’échanges, OpenAI a créé un véritable moteur de réponse.

Pour en apprendre davantage sur le fonctionnement de ChatGPT, je vous conseille le visionnage de la vidéo suivante sur la chaîne de Fred Bobet, avec l’intervention de Sylvain Peyronnet, spécialiste des algorithmes de recherche et co-fondateur des outils SEO Babbar.tech et Yourtextguru :

Les limites des modèles NLP actuels

Les modèles de langage de type GPT-3 se nourrissent des données présentes sur le web jusqu’à une certaine date (2021 il me semble). La pertinence de ses réponses est donc particulièrement au rendez-vous sur des sujets communs. Elle perd en pertinence en revanche sur des sujets d’actualité.

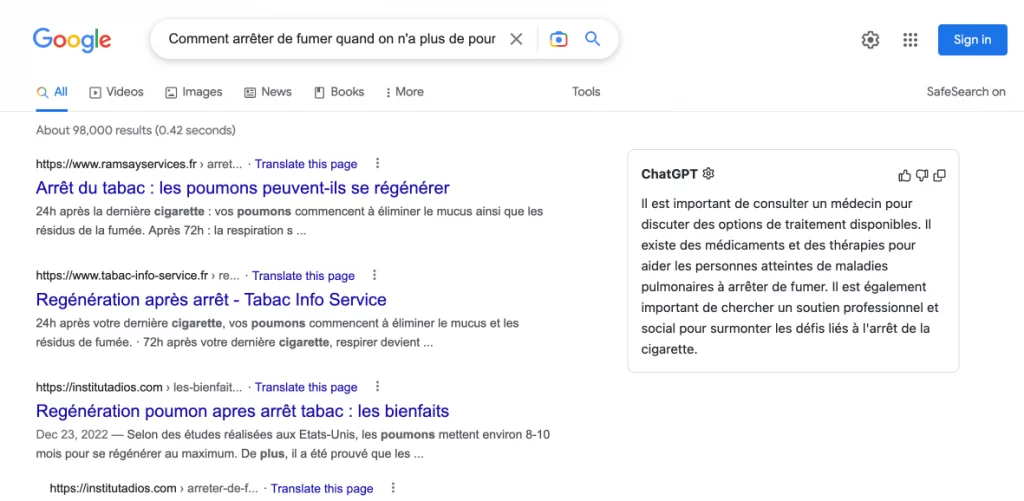

C’est ici que les moteurs de recherche ont encore une longueur d’avance. Il n’empêche que certains se sont amusés à développer eux même des extensions de navigateur permettant directement d’intégrer le modèle ChatGPT dans leur moteur de recherche. En plus d’avoir une liste de résultats de sites web, l’utilisateur obtient également une réponse précise à sa question via un bloc de chat. Et ce, avant que Microsoft débarque avec la nouvelle version de Bing.

1ère intégration officielle de l’IA dans les moteurs de recherche

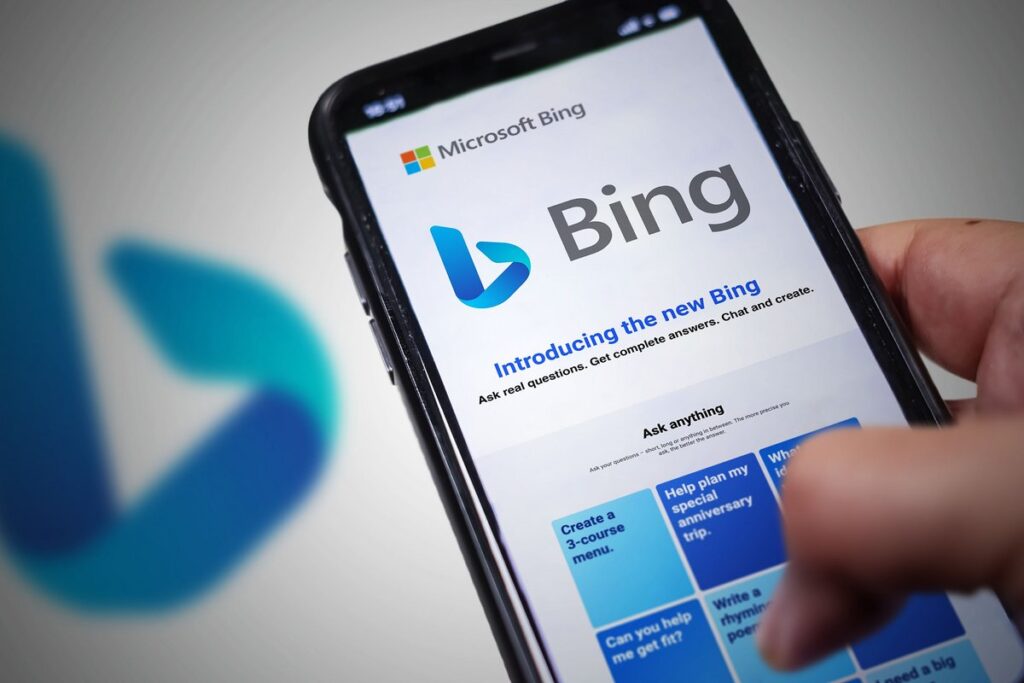

Pour venir à bout des limites d’un tel moteur de réponse, il ne manquait plus qu’une intégration officielle d’un grand acteur. C’est dans la soirée du 7 février 2023 que Microsoft annonce la nouvelle version de son moteur de recherche historique Bing.

Démonstration à l’appui, Microsoft montre la puissance de l’intégration de la technologie GPT d’OpenAI directement dans son moteur de recherche. Ainsi, en connectant directement ce modèle NLP à Internet, Microsoft rend la base de connaissances du chatbot, jusqu’ici « statique », « dynamique ».

Quel impact sur le SEO ?

L’impact sur le travail d’optimisation du référencement naturel est donc assez net. Pour faire face à ce type de chat, les sites internet vont devoir redoubler d’efforts, pour proposer des contenus riches, bénéficiant d’une véritable expertise et s’appuyant sur divers supports (images, vidéos, podcasts, etc.).

Autre impact et non des moindres, la productivité de l’humain sur certains secteurs comme la rédaction de contenu ou le développement de code est décuplée. Il n’est plus question de passer du temps à rédiger et optimiser contenus par contenus mais plutôt de créer des prompts ultra précis à fournir au modèle de langage pour produire à grande échelle.

Outre l’automatisation possible de tâches fastidieuses, l’impact le plus notable aujourd’hui est dans la rédaction de contenu.

Les applications de l’IA

J’en parlais un peu plus tôt, mais avant ChatGPT, l’utilisation de modèles de langage de type GPT-3 nécessitaient des connaissances techniques particulières.

Pour produire à une certaine échelle, il fallait développer des scripts qui permettaient de générer des contenus, selon les paramètres fournis. On pouvait ensuite entrainer le modèle sur des contenus d’un secteur précis pour qu’il s’en inspire et devienne de plus en plus efficace.

Toutefois, ce type de travail s’adressait à de véritables connaisseurs. En France, nous pouvions notamment retrouver les formations de Vincent Terrasi, expert sur le sujet.

Mais pour s’adresser au plus grand nombre et rendre cette technologie accessible à tous, de nombreux acteurs ont développé leur propre logiciel intégrant GPT-3, avec une interface dédiée, et avec des modèles entrainés dans des objectifs précis (rédaction de mail, fiche produits selon la méthode AIDA, etc.).

Si l’accessibilité nouvelle de ChatGPT change quelque peu la donne, cela ne rend pas ces outils caducs pour autant.

Travaillant dans le milieu du SEO en agence, la problématique de productivité de la rédaction de contenu touche mon quotidien. Générer massivement des contenus est un besoin réel sur nos métiers. C’est pourquoi je me suis vite intéressé à ce type d’outils. Ayant pu tester un grand nombre d’entre eux, je vais donc pouvoir vous proposer des avis précis et exhaustifs sur ces outils.

Quelques exemples d’outil de rédaction de contenu IA :

- Jasper AI (Lire mon avis sur Jasper AI)

- Writesonic (Lire mon avis sur Writesonic)

- Rytr

- Headlime (Lire mon avis sur Headlime)

- ShortlyAI (Lire mon avis sur ShortlyAI)

Les applications de l’intelligence artificielle ne s’arrêtent évidemment pas à la rédaction de contenu. Et nous aurons l’occasion d’analyser d’autres usages dans de futurs articles.

La réponse des moteurs de recherche

Il est établi que nous entrons dans une nouvelle ère du web. Que ce soit en termes d’usage, de productivité, ou au niveau des métiers. Un rédacteur web pourrait devenir un rédacteur de prompts optimisés par exemple. Mais pour répondre à ce changement d’usage, les moteurs de recherche doivent aussi s’adapter.

Comment qualifier la qualité d’un contenu ? Comment discerner le travail d’un humain d’une intelligence artificielle ? Les questions se posent. Et il semblerait que les moteurs de recherche comme Google n’aient pas encore toutes les réponses.

De nombreuses Core update vont voir le jour, et si certains outils arrivent déjà à détecter si un contenu a été rédigé par une intelligence artificielle, Google devrait également pouvoir le faire.

Mais un contenu rédigé par une IA n’est pas forcément synonyme de faible qualité. C’est là que la difficulté d’interprétation apparait. Le concept E-A-T, utilisé par les quality raters de Google devrait alors se renforcer. Pour déterminer la qualité d’une page ou d’un site, d’autres facteurs devront entrer en jeu. Le taux de rebond, le nombre de vues, le temps passé sur une page, le nombre de partage sur les réseaux sociaux, le taux de présence de la marque, etc.

Le travail des SEO devra s’adapter à ce changement, et ainsi devenir davantage holistique que par le passé.

Laisser un commentaire